INTRODUCCIÓN

Jamás a lo largo de la historia de la humanidad se ha producido un fenómeno de desarrollo tecnológico de la comunicación, como el manifestado en escasamente 200 años que nos preceden. Nos hallamos en una era de invenciones sin igual, en múltiples campos, donde las telecomunicaciones constituyen uno de los vértices más importantes de esa revolución tecnológica.

Para entender el contexto de esta aceleración, podemos considerar el esquema de J. H. Robinson, donde toda la vida de la Humanidad se reduce a 24 horas, y el aproximadamente cuarto de millón de años en que el hombre lleva preocupado por mejorar sus condiciones de vida, sería la hora 12. En esta escala de tiempo, hace 11 horas y media que sólo tenemos conocimiento de restos de utensilios y pinturas rupestres, y ningún dato acerca de personajes o acontecimientos. Hace veinte minutos aparecen los primeros vestigios sobre Babilonia y Egipto. La ciencia, literatura y filosofía griega, que tan antigua consideramos, es de hace sólo siete minutos. La electricidad y la máquina de vapor fueron descubiertas hace menos de un minuto. Y sólo hace cinco segundos que se descubrió el transistor, al cual haremos referencia más tarde por el gran impacto que supuso en la vida de la sociedad contemporánea.

Las comunicaciones terrestres, aéreas y marítimas, así como el campo de las energías, la medicina o la salud, por nombrar algunos, han recibido en las últimas décadas un impulso de tal magnitud que no existe comparativa posible con las diferentes etapas evolutivas del hombre. Estas tecnologías alcanzaron cotas insospechadas cuando el primer ser humano fue impulsado hacia el espacio exterior, le permitieron orbitar la Tierra e incluso poner un pie por primera vez sobre la superficie de nuestro satélite.

El nacimiento de Internet, un fenómeno que bien podría dar nombre a una nueva era, así como las tecnologías inalámbricas, constituyeron avances tan notables que es difícil hallar un ejemplo de evolución similar en el largo periodo histórico desde que la humanidad abandonó la vida silvestre para establecerse en sociedades.

El descubrimiento de la onda electromagnética, junto a la válvula electrónica precursora del transistor, pusieron los cimientos de esa admirable era. La radio, la televisión, las comunicaciones intercontinentales fueron entonces posibles. Con estos mimbres, la telefonía inalámbrica no podía tardar en nacer y popularizarse, hasta convertirse en un medio de masas cada vez más complejo, donde transmitir y recibir la voz es sólo una de sus posibilidades, junto a otras variadas funcionalidades.

En la actualidad se consume información en ingentes cantidades por múltiples vías y dispositivos analógicos o digitales. Las facilidades para obtener contenidos distribuidos mediante radio, podcast o aplicaciones, junto a las variadas tecnologías de equipos de reproducción, muchos de ellos inalámbricos, han ayudado a crear una pujante industria electrónica y de comunicación. Esto ha provocado una demanda de información sobre los productos ofertados por los diferentes fabricantes y, en consecuencia, se han popularizado también las webs de testeo y prueba de producto, con objeto de orientar y aportar información a los usuarios en el proceso de compra.

Hoy, con el auge de Internet de las cosas, los tiempos del cableado van llegando a su fin progresivamente, siendo las tecnologías inalámbricas un recurso tan extendido que ya forma parte rutinaria de nuestra vida diaria.

LOS MENSAJEROS

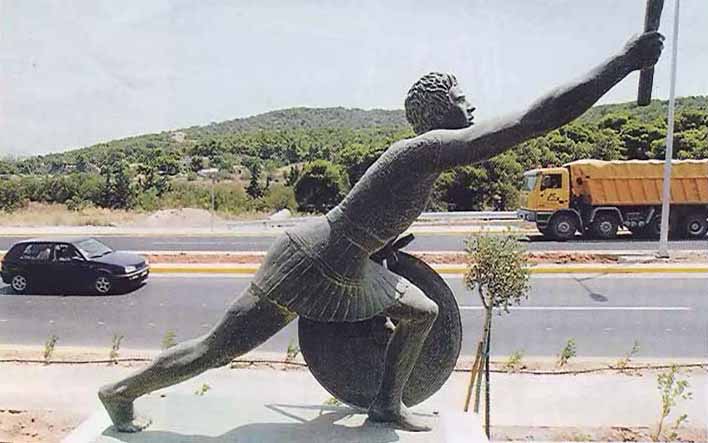

Cuando la humanidad abandonó el nomadismo y se asentó en comunidades, persiguió la forma de comunicarse en la distancia. Se ensayaron variados métodos, cada cual con sus ventajas e inconvenientes, siendo los mensajeros a pie o a caballo el primer recurso para transmitir información entre dos puntos distantes. El historiador y geógrafo griego Heródoto, cuenta en sus crónicas que en el 490 a.C. un ateniense llamado Filípides corrió descalzo en menos de dos días los 260 km entre la población de Maratón y Esparta, para entregar un mensaje a los espartanos de los comandantes de Atenas pidiendo ayuda, pues el poderoso ejército persa había desembarcado en Maratón y amenazaba a Grecia.

Filípides regresó y fue testigo de cómo los griegos vencían a los invasores persas en la batalla de Maratón, partiendo después hacia Atenas para llevar la noticia. Tras recorrer los últimos 40 km que le separaban murió extenuado. Esta hazaña inspiraría un agotador evento deportivo de las Olimpiadas: el maratón.

EL TAMTAM

El tambor fue otro método de transmisión de información que tuvo su mayor auge entre los habitantes de zonas selváticas, donde las señales visuales resultaban más complicadas de utilizar. Los nativos de África, América o Nueva Guinea, por ejemplo, construían sus telégrafos de tambor, el conocido como Tamtam, mediante madera de los árboles, una materia prima que siempre tenían a su alcance.

Los tamtam, aunque fueron una forma temprana de comunicación en la distancia, también asumieron funciones de carácter religioso o ceremonial.

LAS SEÑALES VISUALES

Las señales visuales pretendían minimizar los problemas que surgían con el uso de mensajeros. Aunque estos podían portar información clara mediante escritos, no resultaban eficientes porque resultaban fácilmente interceptables, además en determinadas situaciones el tiempo empleado en recorrer una distancia podía invalidar este método.

Alrededor del 1184 a.C. ya se manejaban transmisiones a distancia visual mediante señales de fuego. Como suele suceder habitualmente, fue en el ámbito militar donde nacieron y se desarrollaron muchas tecnologías, también las de comunicación. Hacia el 150 a.C., los romanos ya utilizaban sistemas de señales de fuego combinado con telégrafos de columnas de humo, para comunicar sus diferentes campamentos que tenían distribuidos en una extensión de 4.500 km a lo largo de todo su vasto imperio. Los cartagineses también utilizaban antorchas para comunicarse; un empleo significativo de ese sistema sucedió en la impresionante marcha a través de los Alpes de Aníbal contra Roma durante la Segunda guerra púnica.

El telégrafo hidro-óptico

Desde luego, las señales visuales fueron las más socorridas a lo largo de la historia de la comunicación humana. Se intentaron muchos ingenios, unos con más fortuna que otros. Además de los primitivos telégrafos de humo, surgieron sistemas de agua, combinados de fuego y agua, de semáforo, etc. El de humo o fuego resultaba muy limitado, pues las hogueras en lo alto de las torres sólo podían indicar que algo sucedía, pero no expresar el qué. Este inconveniente se solventó en gran medida mediante el sistema de fuego y agua conocido como telégrafo hidro-óptico, muy popular en el imperio romano. Fue inventado por Eneas el Táctico alrededor del 350 a.C., y según el historiador romano Polibio se utilizó durante la Primera guerra púnica para enviar mensajes entre Sicilia y Cartago. Al demostrarse el telégrafo hidro-óptico suficientemente eficaz, para el 150 a.C. ya existían alrededor de 3000 redes con este sistema cubriendo todo el imperio romano.

El telégrafo hidro-óptico consistía en depósitos o barriles idénticos situados en lo alto de colinas distantes, pero que tenían visión directa entre ellos. Antes de enviar un mensaje, los depósitos se rellenaban con agua, y en su interior flotaba una varilla vertical que tenía grabados una serie de códigos, cada uno de ellos se correspondía con un mensaje predeterminado.

El operador que transmitía, antes de enviar el mensaje utilizaba una antorcha para indicar al operador que recibía que se disponía a transmitir. Cuando el receptor confirmaba con su propia antorcha que estaba listo para recibir, ambos abrían de forma simultánea las válvulas que había en el fondo de cada depósito.

Conforme el agua iba bajando de nivel, también lo hacía la varilla, y justo en el momento que la marca correspondiente al mensaje deseado alcanzaba el borde del recipiente, el emisor ocultaba su antorcha para indicar que la transmisión había finalizado. En ese justo momento ambos operadores cerraban las válvulas simultáneamente. Después el receptor podía leer el mensaje inspeccionando la marca de la varilla flotante que se mostraba en el borde del recipiente. El receptor, podía convertirse en transmisor y realizar la misma operación para enviar el mensaje a otro puesto en otra colina distante, y así ir enlazando todos los puestos hasta que el mensaje llegase a su destino.

Gallardetes y banderas

Como se dijo, el ámbito militar fue propicio para la invención y desarrollo. La Marina castellana que luchaba contra las naves del reino de Aragón, adoptó en 1340 la telegrafía de señales mediante gallardetes de diferentes colores, permitiendo comunicar a los mandos órdenes y noticias codificados.

El sistema de los gallardetes y banderas no declinó, de hecho en la actualidad está vigente el código internacional de señales marítimas de la Organización Marítima Internacional (el primer código lo creó la Agencia de Comercio Británica en 1855), compuesto por banderas de diferentes formas y colores, que permiten cubrir todo el alfabeto y los números del 0 al 9. Cada bandera tiene su propio significado, pero se pueden realizar combinaciones de varias banderas y así ampliar el número de mensajes según unos códigos predeterminados; también se pueden enviar mensajes textuales utilizando el carácter y los números que corresponden a cada bandera. El código puede utilizarse para comunicar entre dos barcos, o entre un barco y tierra.

El telégrafo óptico

En la Edad Media la situación en tierra seguía conservando las limitaciones propias de las redes primitivas, las cuales podían transmitir mensajes con relativa rapidez, pero con un conjunto de signos muy escaso, en consecuencia los mensajes carecían de un vocabulario suficientemente amplio. Se seguía persiguiendo un método que permitiera enviar y recibir textos más cercano a la comunicación escrita.

Así, en 1684 el científico británico Robert Hooke ideó un sistema de telégrafo óptico pero nunca lo puso en práctica. Casi cien años después, el inventor angloirlandés Sir Richard Lovell Edgeworth experimentó con una señalización óptica para transmitir los resultados de una carrera. Consistía en un puntero grande que podía orientarse hasta ocho posiciones distintas en incrementos de 45º. Con dos punteros se podían componer hasta 64 posiciones, y con tres hasta 512. El invento no tuvo mucho éxito y quedó relegado.

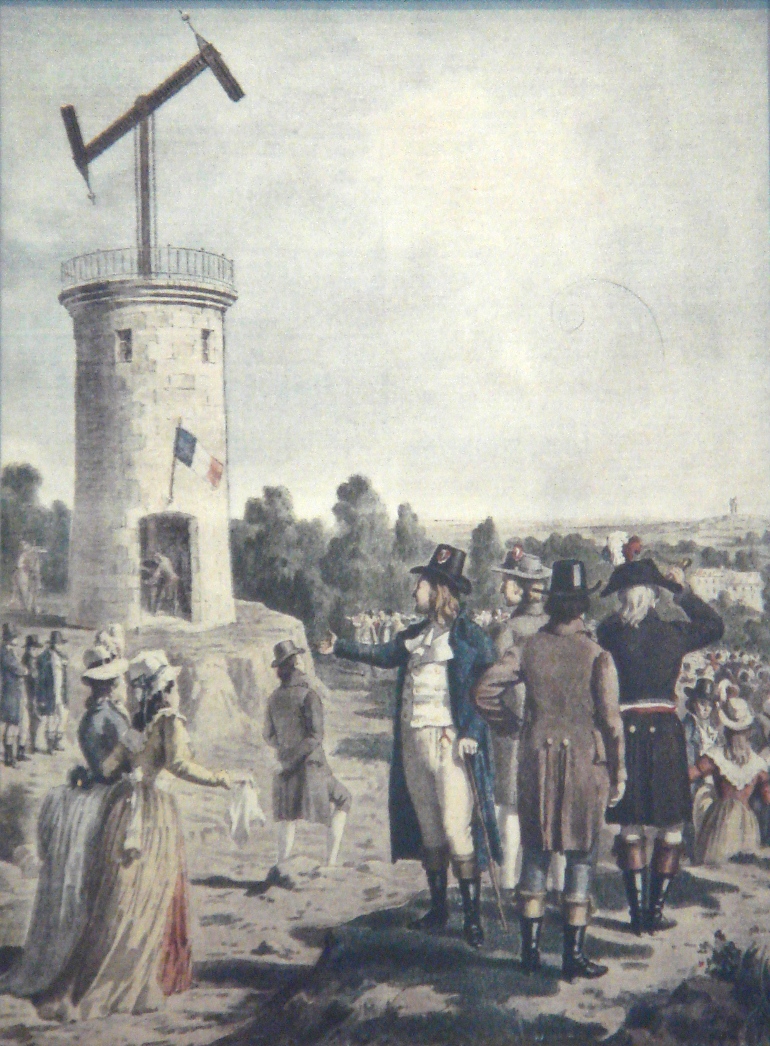

No sería hasta el siglo XVIII, en que el inventor francés Claude Chappe diseñaría un telégrafo óptico funcional basado en el sistema de Lovell. El invento vio la luz en 1792, y tras su demostrada eficacia puede ser considerado como el primer sistema práctico de telecomunicaciones. El éxito de este telégrafo fue tal que Francia creó una red de 556 estaciones cubriendo una extensión de 4.800 km. Aunque en principio se diseñó para uso comercial, Napoleón Bonaparte lo adoptó para coordinar sus tropas en la distancia.

El sistema de Chappe se componía de un mástil del que partía una barra con dos brazos móviles de dos metros de largo cada uno. La barra y los brazos podían moverse mediante unas palancas y según su posición determinaban la letra o el número que se deseaba transmitir. Combinando las distintas posiciones de las partes móviles era posible fijar hasta 196 figuras distintas. Al principio se le asignó una sílaba a cada figura, al estilo de la taquigrafía, pero posteriormente fue sustituido por un vocabulario de 92 páginas y 92 palabras en cada página, por lo que sólo eran necesarios dos símbolos para componer una palabra.

La primera línea telegráfica con el sistema de Chappe se puso en marcha en 1794, con 22 estaciones que cubrían 240 km entre Lille y París. Transmitir un mensaje empleaba entre 2 y 6 minutos, pero el receptor final podía necesitar hasta 30 horas para leerlo e interpretarlo. En menos de una década el telégrafo de Chappe traspasó fronteras y y se extendió por toda Europa.

EL TELÉGRAFO ELÉCTRICO

Los descubrimientos de Ampere y Faraday sobre la corriente eléctrica y la inducción electromagnética, vendrían a dar un vuelco a la forma de comunicarse, poniendo las bases para el desarrollo del telégrafo eléctrico, un aparato que permite transmitir mensajes codificados a larga distancia. El físico estadounidense Joseph Henry construyó el primer aparato de telegrafía eléctrica en 1829, pero quien le dio el gran impulso fue el inventor, también estadounidense, Samuel Morse, que consiguió enlazar telegráficamente por primera vez Washington y Báltimore en 1844.

Los primeros telégrafos eléctricos marcaban una cinta con puntos y rayas mediante un electroimán que al paso de la corriente se activaba, pasando a reposo al cesar la corriente; los operadores leían esos códigos para componer el mensaje. Más tarde se utilizaron dispositivos que producían sonidos, entrenándose los operadores en recibir los tonos de puntos y rayas que correspondían a cada carácter.

Morse, ideó en un principio un código para transmitir sólo números en base al sistema del telégrafo óptico, utilizando un libro de códigos donde cada número se correspondía con una palabra. Aunque existe controversia, parece que fue Alfred Vail quien amplió el código en 1840 incluyendo también letras y otros caracteres; el código se basaba en tres símbolos: una pulsación corta (un punto), una pulsación larga (una raya) y un tiempo de silencio (espacio entre letras y palabras). Desde 1844, el «Código Morse Americano» se mantuvo vigente hasta finales del siglo XX, en que los nuevos medios de telecomunicación lo fueron desplazando hasta quedar prácticamente en desuso, salvo para los radioaficionados que lo siguen conservando en sus comunicaciones.

EL TELÉFONO

El teléfono fue inventado por el italiano emigrado a Estados Unidos Antonio Meucci, que construyó su prototipo en 1854 con la intención de conectar la planta baja de su casa (donde estaba ubicada su oficina), con la habitación de su esposa, que se hallaba inmovilizada por el reumatismo. Meucci incluso realizó una demostración pública del invento, que llamó teletrófono, transmitiendo la voz de una cantante a una distancia considerable. Meucci no tenía dinero para patentar su invento, aunque realizó una descripción del mismo ante la oficina de patentes de Estados Unidos en 1871. A pesar de que la prensa se hizo eco, no consiguió que se materializara ninguna oferta para su producción.

En 1876, Alexander Graham Bell registra la patente de su teléfono de resistencia variable, y curiosamente dos horas después en otra ciudad era presentada por el inventor estadounidense Elisha Gray una solicitud de patente de un ingenio similar. Al ser Elisha Gray conocedor de este hecho, desafió la patente de Graham Bell, pero tras años de litigio se entregaron a éste los derechos. Meucci también intentó a través de un abogado hacer valer la titularidad del invento, pero toda la documentación que había presentado en la oficina de patentes desapareció misteriosamente; se supo después que el poderoso Graham Bell había sobornado al abogado de Gray, y que también tenía un confidente en la oficina de patentes que actuó en su favor.

Durante muchos años, Graham Bell y Elisha Gray fueron considerados coinventores del teléfono. Debieron transcurrir más de cien años, para que el 11 de junio de 2002 el Congreso de los Estados Unidos reconociese formalmente mediante una resolución, que el verdadero inventor del teléfono fue Antonio Meucci.

Independientemente de estas cuestiones procedimentales, el ingenio evolucionó rápidamente, mejorando en la calidad de transmisión de la voz y la distancia alcanzada. En el siglo XX, con la aparición del transistor y las centrales de conmutación automática, se simplificaron notablemente los sistemas de intercomunicación, alcanzando cotas de notable complejidad técnica con la aparición de los sistemas digitales y la fibra óptica.

LA RADIOCOMUNICACIÓN

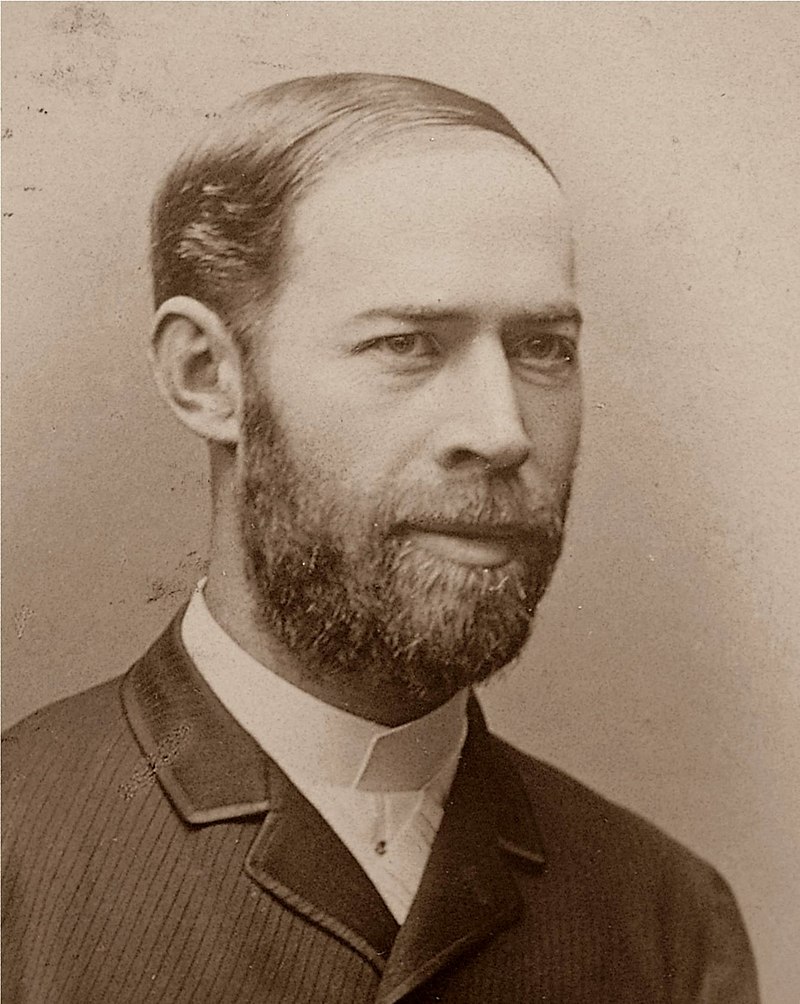

La radiocomunicación y la radiodifusión fue otra área de la tecnología que cambiaría para siempre las formas de intercomunicación y de consumo de información. Comenzó tímidamente con el descubrimiento de la inducción eléctrica por Michael Faraday en 1821, al conseguir realizar el primer generador de corriente eléctrica a partir de energía mecánica, y también gracias a los estudios de Maxwell en 1864 sobre la dinámica de los campos electromagnéticos.

Veinte años después, Heinrich Rudolf Hertz pudo demostrar que era posible radiar una corriente alterna a través del éter, utilizando un generador de chispas con dos bolas metálicas. Herth sólo alcanzó radiar unos pocos metros con su ingenio, e ignorando la gran trascendencia que tendría lo arrinconó en un laboratorio. En su honor, el término «ondas hertzianas» fue acuñado para llamar a las ondas de radio o electromagnéticas.

Pero, dos décadas más tarde varios investigadores sintieron interés por los experimentos de las ondas hertzianas, como el físico inglés Oliver Joseph Lodge, o su homólogo ruso Aleksandr Stepánovich Popov, éste había conseguido transmitir por radio las primeras palabras en código Morse. El serbio nacionalizado estadounidense Nikola Tesla también hizo importantes aportes al desarrollo de la radio, como la «bobina de Tesla», y de hecho existe controversia de si el verdadero inventor de la radio fue Popov, Tesla o Guillermo Marconi. Éste fue un inventor italiano que dio una auténtica aplicación práctica a las teorías de Hertz, construyendo en 1897 una emisora que consiguió enviar una señal en código Morse a un remolcador en la mar situado a treinta kilómetros de distancia. El transmisor inalámbrico de Marconi fue un éxito, y en pocos años numerosos buques partían hacia la mar equipados con una radio Marconi.

La radio, como medio de difusión pública, tuvo su primera emisión el 24 de diciembre de 1906, de la mano del profesor canadiense Reginald Aubrey Fessenden. Utilizando un transmisor de chispa con una antena de 128 metros de altura, se pudo transmitir con éxito la voz humana y una pieza musical de Haendel. Pero, la primera emisión de audio del mundo sucedió seis años antes, cuando el propio Fessenden consiguió transmitir de forma inalámbrica la voz humana a unos 1,6 kilómetros de distancia.

Fessenden fue un inventor precoz en el campo de la radio y otros dispositivos de transmisión, como el sonar y la televisión. También teorizó sobre el principio del receptor heterodino, que utiliza dos señales combinadas para producir una tercera señal audible, pero imposible de probar en aquellos momentos en que los receptores utilizaban galena, pues la válvula electrónica (precursora del transistor) estaba recién nacida. No sería hasta 1915, con la evolución del tubo de vacío, que se pudo construir la válvula triodo y poner en práctica la teoría heterodina de Fessenden, dando un espectacular impulso no sólo a la telefonía por radio, sino a la propia radio y otras variadas invenciones que empleaban las ondas hertzianas.

EL TRANSISTOR, EL COMPONENTE QUE LO CAMBIARÍA TODO

En la década de 1940, un grupo de técnicos muy cualificados reunidos por los laboratorios Bell, de la compañía American Telegraph and Telephone, se dedicaron al estudio de la física de estado sólido, particularmente los semiconductores. Éstos son cuerpos que tienen un propiedad eléctrica curiosa: no son ni conductores ni aislantes, y su estado puede ser cambiado gracias a que presentan en su constitución física unas pequeñas cantidades de impurezas.

Tras numerosos ensayos, y también fracasos, John Bardeen, Walter Brattain y Wiliam Bradford Shockley, consiguieron en 1948 algo revolucionario, el primer transistor de laboratorio, un componente que se halla hoy en día en cualquier dispositivo imaginable, desde un teléfono, un ordenador, un televisor, un reloj de pulsera, el mando a distancia… Esta invención les valió a los citados la concesión del premio Nobel de Física en 1956.

«Transistor» es un acrónimo de «transfer» (transferencia) y «resistor» (resistencia); es decir, es un dispositivo transferidor de resistencia. Regulando la resistencia se puede actuar sobre la corriente; en este sentido el transistor permite controlar una gran corriente a la salida, cuando circula una pequeña corriente en la entrada, o sea, es capaz de amplificar señales. Al principio, el transistor tuvo que competir con la más que probada válvula electrónica o termoiónica (ambos podían amplificar señales), pues la válvula ganaba en robustez y fiabilidad. Los primeros transistores presentaban el problema de la limitación de temperatura, potencia y frecuencia, entre otros. Pero, como ha sucedido con muchos ingenios a lo largo de la historia tecnológica, la constante investigación vino a situar el transistor en el lugar que le corresponde. Tras un paciente y tenaz trabajo, pudieron ponerse de manifiesto las indudables ventajas que ofrecía el transistor con relación a la válvula electrónica. En primer lugar sobresale el tamaño: en el volumen de una sola válvula podían alojarse varios cientos de transistores, aunque con la tecnología actual en el espacio de una uña se podrían integrar la increíble cifra de 20.000 millones de transistores; imaginemos las primeras computadoras a válvulas, las cuales podían ocupar una habitación entera, con transistores podía quedar reducido al tamaño de un folio. Por otro lado destaca el menor consumo de energía del transistor, y una notable mejora en la seguridad de funcionamiento al trabajar con voltajes mucho más reducidos que las válvulas. Tampoco debemos dejar de lado el aspecto económico: un dispositivo a transistores reduce su coste notablemente con relación al mismo dispositivo construido con válvulas, permitiendo que muchas tecnologías puedan llegar más fácilmente al gran público.

El transistor halló rápidamente una amplia gama de nuevas aplicaciones, como las radios portátiles, de hecho en sus primeros tiempos, el pequeño aparato de radio a transistores era conocido popularmente como «el transistor». La notable reducción de tamaño también permitió el diseño y construcción de dispositivos auditivos para sordos, marcapasos para patologías del corazón, etc. Cuando la humanidad consiguió poner una nave en el espacio, fue en gran parte a la tecnología de los semiconductores.

Los equipos portátiles a transistores se hicieron populares; las telecomunicaciones ganaron sobremanera, especialmente las embarcaciones y las aeronaves, al permitir dotarse de dispositivos de comunicación seguros y manejables. En la actualidad la mayoría de los aparatos que utilizamos en nuestra vida diaria tienen algún transistor, o placas de transistores integrados entre sus componentes.

UNA NUEVA ERA: INTERNET Y LA REVOLUCIÓN DIGITAL

La informática

El origen de internet es casi sinónimo de origen de informática, pues ésta no habría alcanzado las actuales cotas de presencia en la sociedad sin la aparición de la Red de redes. La primera persona en utilizar el término «informática» fue el científico alemán Karl Steinbuch en 1956, cuando añadió la palabra alemana Informatik en la publicación de un documento sobre procesamiento automático de información. El físico francés Phillipe Dreyfus tomó el término de Steinbuch (en francés informatique) y lo popularizó en 1962, siendo el que trascendió a otros idiomas, como el inglés.

Pero todo lleva su proceso y su tiempo, pues en la década de 1950 la informática no consistía en otra cosa que intentar realizar operaciones aritméticas lo más rápido posible. Para entonces, en Estados Unidos el físico John William Mauchly y el ingeniero eléctrico John Presper Eckert, ya habían conseguido construir el primer ordenador totalmente digital en 1946, el ENIAC (Electronic Numerical Integrator And Computer), que ocupaba toda una habitación de 6×12 metros, pesaba 27 toneladas y se tardó casi tres años en su construcción. Estaba compuesto por 1.500 relés, 70.000 resistencias, 7.200 diodos de vacío, 10.000 condensadores y unos cinco millones de soldaduras hechas a mano. Introducir la información para su proceso no resultaba tan fácil como en los ordenadores actuales, donde un intérprete convierte nuestro lenguaje humano al único que entienden las computadoras, el código binario; en el ENIAC había que introducir las instrucciones mediante código máquina, es decir en binario o en hexadecimal. El ENIAC evolucionó hacia el UNIVAC I, que sería en 1951 la primera computadora comercial fabricada en Estados Unidos. Era la primera generación de ordenadores.

Alrededor de 1953 la IBM (International Business Machines Corporation) que hoy en día es mundialmente conocida como una multinacional fabricante de hardware y software para computadoras, en aquellas fechas era en realidad un fabricante de relojes, el mayor de Estados Unidos. Pero, en 1958 IBM se deshizo de ese departamento y se centró en la tecnología, dando un salto hacia los ordenadores. No eran ordenadores mejores que el UNIVAC I, pero el departamento de ventas de la compañía realizó una formidable campaña comercial, consiguiendo para finales de la década situarse por encima de los fabricantes competidores, alcanzando ventas que superaban los mil millones de dólares.

Por la misma época había otros proyectos enfocados en computadoras, como la máquina Whirlwind desarrollada en el Instituto Tecnológico de Massachusetts (MIT), y otras empresas implicadas como NCR, Buroughs, HoneyWell, etc., que comenzaron a consolidar este mercado.

Para comienzos de la década de 1960, ya había llegado a los consumidores la segunda generación de ordenadores, al reemplazar las válvulas electrónicas de vacío por los transistores, consiguiéndose reducir notablemente el tamaño de las máquinas y el consumo de electricidad. Al mismo tiempo se mejoran las formas de enviar las instrucciones, al nacer los «lenguajes de alto nivel», en los que no era necesario conocer los entresijos del hardware, acercándose más al lenguaje humano. A partir de 1964 se desarrollan los circuitos integrados, en los que se podían unificar miles de componentes electrónicos, esto permitió el nacimiento de la tercera generación de ordenadores.

La cuarta generación de ordenadores nace con el reemplazo de las memorias de núcleos magnéticos por chips de silicio, y con el desarrollo del microprocesador Intel 4004 en 1971, una tecnología fruto de los circuitos integrados que permitía realizar 60.000 operaciones por segundo.

La siguiente generación de ordenadores consistiría en una constante evolución donde una internet incipiente la llevaría a cotas jamás presupuestadas en la historia de la tecnología y las comunicaciones. La década de 1980 sería la del nacimiento de la Red de redes, cuya implantación y desarrollo cambiaría para siempre la forma de comunicarse de la humanidad.

ARPANET, la semilla de internet

Terminada la Segunda Guerra Mundial, las dos superpotencias, Estados Unidos y la antigua Unión Soviética, se embarcaron en una guerra fría que pasó por momentos delicados con la crisis de los misiles en Cuba, y no finalizaría hasta la caída del muro de Berlín en 1989. Pero, aquella «guerra» sin armas hacía trabajar sin descanso a los servicios de inteligencia y también a los científicos encargados de investigar sobre tecnología de contramedidas. En ese ambiente, y paralelamente al desarrollo de la informática a mediados del siglo XX, se producían unos hechos que encadenarían el nacimiento y evolución de Internet como hoy la conocemos.

En 1957 la Unión Soviética lanzaba al espacio el primer satélite artificial, el Sputnik, tomando por sorpresa a Estados Unidos en la batalla tecnológica; esto era indicio de que la URSS podía además adelantarse también en el campo de los misiles intercontinentales. El 9 de octubre de 1957, sólo cinco días después del lanzamiento del Sputnik, el presidente Eisenhower, aunque él mismo era militar, decidió nombrar como secretario de Defensa a Neil McElroy, un civil sin ninguna experiencia de armas salvo por haber realizado el servicio militar obligatorio, y que en aquellos momentos era presidente de una empresa de jabones, la Procter&Gamble, hoy en día una multinacional distribuida por todo el mundo.

McElroy, ya en el ejercicio de su cargo, fue consciente de que era necesario diseñar algún organismo científico que pudiese competir con los avances tecnológicos de los soviéticos, así que diseñó un plan y lo llevó al Congreso donde lo expuso con detalle. A pesar del descontento de los militares, por entender que invadía su terreno, McElroy no sólo obtuvo la aprobación, sino que su proyecto fue respaldado con una notable inyección económica.

Así, el 7 de enero de 1958, ese civil recién llegado a secretario de Defensa fundó «ARPA» (Advanced Researchs Projects Agency), formado por unos 200 científicos muy cualificados que disponían de un gran presupuesto para sus investigaciones. Sus objetivos se centraron en crear comunicaciones directas entre ordenadores para conseguir entrelazar las diferentes fuentes de investigación.

La existencia de ARPA estaba fundamentada, pues finalizando la década de 1960 la tensión entre las dos superpotencias no había decaído, apareciendo la temida amenaza en forma de misiles intercontinentales con cabezas nucleares. La capacidad de reacción ante el lanzamiento de misiles de esas características, que podían alcanzar otros continentes sin dar tiempo a reaccionar, evidenciaba que los humanos no podían encargarse de esa misión. La única forma de detectar los misiles y destruirlos en vuelo antes de alcanzar sus objetivos sólo era posible mediante computadoras que pudieran actuar interconectadas entre si.

Surgieron aquí las dificultades propias de las redes informáticas típicas de las empresas y universidades, donde las máquinas están centralizadas, es decir, los ordenadores de una red suelen comunicarse con otros ordenadores pasando previamente por otro ordenador que hace la función de servidor central. Para los militares esto era un problema, pues si el ordenador central era destruido en un ataque, todos los ordenadores dependientes quedaban inoperativos. Se especuló entonces con duplicar e incluso triplicar o cuadruplicar los ordenadores centrales para aumentar la seguridad, pero ante esa disyuntiva alguien propuso ¿porqué no hacer que todos los ordenadores sean centrales?, es decir, que la red careciese de nodos centrales y que cada uno de ellos fuese su propio nodo, de esta forma si algún equipo o varios resultaban dañados los demás ordenadores restantes podrían seguir compartiendo la información entre ellos. ¡Y esa fue la solución adoptada!

No se esperó demasiado, aunque McElroy ya no ocupaba el cargo de Secretario de Defensa, su idea inicial prosperó y el 29 de octubre de 1969 se pone en funcionamiento ARPANET (advanced research projects agency network), una red de ordenadores independientes que inició sus primeros pasos interconectando los cuatro primeros nodos de la historia: las cuatro universidades norteamericanas: California Los Ángeles, California Santa Bárbara, Utah y Stanford. Sus primeras funciones fueron enviar datos militares y conectar grupos de investigación en diferentes lugares de Estados Unidos. Para el control de esta red se utilizó el protocolo NCP (network control protocol, o protocolo de control de red).

Las ventajas de este sistema fueron advertidos inmediatamente y pronto se incorporaron más universidades e instituciones; en 1971 ya había 15 nodos interconectados, y en 1973 ARPANET se internacionalizó al incorporarse a la red nuevos nodos fuera de las fronteras de Estados Unidos: la Universidad College of London de Gran Bretaña y la Norwegian Seismic Array de Noruega.

Diez años más tarde ARPA decidió establecer un estándar para el control de ARPANET y crear el hoy famosísimo protocolo TCP/IP (Transfer Protocol/Internet Protocol). Es aquí donde nace por primera vez la definición de «internet»).

Para el Ministerio de Defensa de Estados Unidos, ARPANET se le había ido de las manos, y en 1983 abandonó este proyecto para crear una red propia y bajo su control absoluto (la red MILNET). Algunos nodos de ARPANET se pasaron a la nueva red militar, pero otros conservaron su estado y permanecieron liberados. A esta red «libre» se fueron uniendo cada vez más nodos en todo el mundo, y este progreso ya sería irreversible. ARPANET finalizó su andadura en 1990, pero su sucesora, INTERNET, comenzó un periodo de evolución y de florecimiento imparable, al que se irían incorporando nuevas tecnologías, muchas de ellas nacidas al margen de la red y evolucionadas por separado, como el correo electrónico que vio la luz por primera vez en 1961, mucho antes de que existiera Internet.

La evolución histórica de INTERNET es tan amplia, que este artículo se tornaría tedioso, tratando de explicar todas las fases implicadas, como el nacimiento del lenguaje HTML, del primer servidor WWW (World Wide Web, o gran telaraña mundial), del navegador de internet (Netscape Navigator, Internet Explorer, Chrome…), de los buscadores de contenido (Yahoo, Altavista, MSN, Google…), de los nombres de dominio, o de todo lo que abarca la «multimedia» (audio, vídeo, imágenes…).

LA REVOLUCIÓN INALÁMBRICA

El teléfono móvil

Los primeros intentos de telefonía móvil comienzan después de la Segunda Guerra Mundial, aunque con anterioridad ya se manejaban radioteléfonos a bordo de embarcaciones, o transceptores portátiles como los walkie talkies, que podían enlazar una llamada telefónica usando operadoras y radioenlaces de VHF/UHF. Mas tarde aparecerían teléfonos tipo maletín, o para ser instalados a bordo de vehículos, y que por su exagerado tamaño no podían ser considerados como portátiles por una persona.

El primer teléfono verdaderamente móvil, es decir portable, que podía sostenerse con una mano y con capacidad para llamar a un número de un abonado telefónico, fue presentado por primera vez en 1973 por Martin Cooper y John F. Mitchell, de la empresa Motorola. Era el DynaTAC 8000x, un aparato que pesaba cerca de 1 Kg; el propio Cooper lo publicitó realizando una llamada con un prototipo desde las calles de Nueva York el 3 de abril de 1973; esa primera llamada la hizo a su competencia, un directivo de la todopoderosa compañía AT&T, que tenía el monopolio de la comunicación telefónica en EEUU.

El DynaTAC era un teléfono analógico, y obviamente en aquel momento primigenio de la telefonía móvil sólo servía para transmitir y recibir la voz (ni siquiera SMS’s, que vendrían más tarde), aunque no fue puesto en el mercado hasta diez años después. Aún faltarían otros diez años más para que aparecieran los primeros teléfonos digitales.

Las generaciones de la telefonía móvil

Los sistemas de telefonía móvil han evolucionado en lo que podríamos llamar generaciones, y en algunos casos incluso subgeneraciones al aparecer pequeños cambios tecnológicos entre las generaciones más significativas.

Primera generación (1G)

Se presentó en EEUU en 1976, funcionaba mediante comunicación analógica, utilizando el estándar AMPS (Sistema telefónico móvil avanzado), el primero para redes celulares trabajando en la banda de 800 Mhz. En Europa se desarrolló la versión TACS (Sistema de comunicaciones de acceso total), trabajando en la banda de 900 MHz. Ésta fue mejorada en Reino Unido por el ETACS (Sistema de comunicaciones de acceso total extendido). Todos estos sistemas de telefonía móvil funcionan dividiendo el espacio geográfico en una red de celdas o células, de ahí lo de telefonía celular.

El sistema 1G tenía prestaciones muy bajas, no permitía enviar datos, sólo la voz.

Segunda Generación (2G)

Esta generación de redes móviles marcó la ruptura con la telefonía analógica, pasando a funcionar en digital. Según el método de digitalización utilizado el 2G se divide en varias tecnologías, como la CDMA (Acceso Múltiple por División de Código), o la TDMA (Acceso múltiple por división de tiempo). Ésta última ha dado lugar a varios estándares tecnológicos en diversos países, siendo el GSM (Sistema global para las comunicaciones móviles) el más extendido. Es posible enviar voz y datos digitales, por ejemplo mensajes de texto SMS. Este estándar fue mejorado con distintas tecnologías que fueron identificadas como subgeneraciones 2G.

Tercera Generación (3G)

Esta generación supuso un cambio importante con respecto al 2G. Con velocidades de hasta 8 Mb, ya es posible ofrecer acceso a internet y servicios de banda ancha, así como interoperatividad y roaming internacional. Es la generación que comienza a facilitar entornos multimedia para la transmisión de imágenes y vídeo en tiempo real. En consecuencia fomenta la aparición de nuevas aplicaciones y servicios, como el comercio electrónico, las videoconferencias, etc.

Esta generación utiliza un estándar llamado UMTS (Sistema universal de telecomunicaciones móviles), capaz de que varios usuarios puedan transmitir a la vez a través del mismo canal sin interferirse, pues cada uno de ellos es identificado por un código único. La mezcla de todas las señales de todos los usuarios aún pareciendo indescifrable, el sistema es capaz de decodificarlas y volver a separarlas perfectamente para cada uno de ellos. UMTS evolucionaría también como sucedió con el 2G a varias subgeneraciones.

Cuarta Generación (4G)

La generación 4G cambia completamente el protocolo y pasa a utilizar IP, es decir, además de un sistema es también una red, y nace por convergencia entre las redes de cable e inalámbricas. En consecuencia esta tecnología permite el uso de modems inalámbricos, smartphones y otros variados dispositivos móviles. Una diferencia notable con la generación 3G es la capacidad de acceso, que supera los 200 Mb cuando está en movimiento, y 1 Gb en reposo. La seguridad de este protocolo permite además ofrecer múltiples servicios, independientemente del lugar y a mínimos costes.

Quinta Generación (5G)

La quinta generación de redes móviles abre una puerta a la innovación tecnológica. El internet de las cosas podrá será una realidad e interconectar equipos, sistemas y dispositivos variados a altas velocidades de carga y descarga a través de un gran ancho de banda, con latencias muy cortas (tiempo que emplean los dispositivos en comunicarse).

Las aplicaciones de 5G permitiría avances en muchas áreas de la tecnología, por ejemplo en el desarrollo de los vehículos autónomos, la realidad virtual, sistemas de alarma, detección o medición en tiempo real, o campos muy importantes como el sanitario.

Las altas velocidades de intercomunicación conseguidas con 5G son posibles gracias a que se utilizan bandas de frecuencias más altas que las actuales (de onda ultra corta). Al utilizar frecuencias altas la potencia utilizada puede reducirse notablemente, y los dispositivos pueden ser aun más pequeños.

Las características que ofrece 5g deja claro que se trata de una tecnología que supera bastante a su predecesora: permite velocidades de datos de 10 Gb, lo que significa hasta 100 veces más que las redes 4G. Su ancho de banda es 1000 veces más rápida. Se pueden interconectar 100 dispositivos más por cada área que las redes 4G. Y el consumo energético de la red se reduce en un 90%.

LAS REDES INALÁMBRICAS

Introducción

El desarrollo sin precedentes de la telefonía móvil en los últimos años, junto con el crecimiento en la riqueza de contenidos propiciado por el servicio WWW (World Wide Web), ha llevado a los usuarios a una revolucionaria «Sociedad de la Información». En este estado evolutivo de internet y las comunicaciones interpersonales, comerciales y empresariales, asoman las tecnologías inalámbricas con tal auge que se han traducido en un notable abaratamiento de costes y su consecuente acercamiento a la población en general.

La estandarización de las redes inalámbricas provocó una expansión en su uso, al permitir que los dispositivos de diferentes fabricantes puedan interoperar entre sí. En consecuencia, se han desarrollado rápidamente múltiples productos y con gran dinamismo una competencia económica y tecnológica.

Según las familias de estándares de las redes inalámbricas, cabe citar las redes de área local (WLAN), las de área personal (WPAN) y las de área metropolitana (WMAN). En las de área local destaca el WIFI, en las de área personal el Bluetooth, y en la de área metropolitana el WiMAX. También se distinguen las redes de área ancha inalámbricas (WWAN), las cuales incluyen las tecnologías vía satélite y todas las redes de telefonía móvil, de las cuales ya hemos hablado anteriormente.

WIFI

El proceso de introducción en las tecnologías inalámbricas vino acompañado por el éxito de un estándar internacional desarrollado por el IEEE (The Institute of Electrical and Electronic Engineers), una asociación técnico-profesional dedicada, entre otras funciones, a la estandarización de sistemas. Nos referimos a las redes inalámbricas de área local WLAN (Wireless Local Area Network), ingeniadas para usar bandas de uso común que no necesitan licencia. Así, el término WIFI (Wireless Fidelity), tan popular en la actualidad, surge como una marca por la WIFI Alliance, con la pretensión de fomentar las tecnologías inalámbricas y las compatibilidades de equipos, y que ha tenido un éxito indiscutible.

Una red WIFI puede emplearse para dar acceso a una conexión a internet, ampliando su alcance, pero también para interconectar dispositivos dentro del hogar o una oficina, prescindiendo así de extender cables para transmitir los datos o cualquier tipo de archivo. Una red WIFI permite conectar una amplia variedad de dispositivos, como ordenadores, impresoras, smartphones, cámaras fotográficas, etc. Otra ventaja es la eliminación del límite de conexiones, al no depender de puertos, pues éstos suelen estar dedicados mediante un puerto para cada dispositivo, y en muchas ocasiones nos vemos obligados a recurrir a puertos extra para dar servicio a todos los equipos que deseamos conectar.

El alcance de una red WIFI depende del tipo de antena que incorpore y del uso de repetidores. Normalmente, las conexiones domésticas a través de un router facilitado por las compañías de telefonía, suelen tener un alcance no superior a los 50 metros, suficiente para cubrir las necesidades habituales de comunicación dentro del hogar o una oficina pequeña.

Bluetooth

La tecnología inalámbrica Bluetooth es un estándar de comunicación por radiofrecuencia que permite eliminar el cableado entre dispositivos móviles y ordenadores. Originalmente se creó con el fin de transmitir voz y datos a unos pocos metros, e interconectar dispositivos dentro de su radio de acción.

Físicamente, un dispositivo Bluetooth consiste en un pequeño microchip que incorpora un radio transmisor en miniatura, el cual puede realizar conexiones de forma inmediata a muy corta distancia (no suele ser superior los diez metros), aunque con amplificadores podría ampliarse hasta los 100 metros, aunque es esa corta distancia lo que le aporta cierta seguridad, al quedar reducido su ámbito a un espacio más personal.

Una ventaja de Bluetooth que también comparte con las redes WIFI, es que opera en la banda de frecuencias entre 2400 y 2483 Mhz, la cual se halla liberalizada en gran parte del mundo, por lo que puede ser utilizada libremente sin necesidad de licencia por parte de los organismos reguladores de las comunicaciones.

WIMAX

Por último haremos un acercamiento a las redes WMAN o de área metropolitana. Como ya se dijo, destaca en este tipo de redes el estándar IEEE 802.16, más conocido como WiMAX (Worldwide Interoperability for Microwave Access).

WIMAX es una tecnología de comunicaciones inalámbrica de un punto a multipunto, diseñada para proporcionar alta velocidad de datos a través de redes metropolitanas, las cuales permiten cubrir un área más o menos extensa dentro de una población o zona rural. Permite que las redes más pequeñas puedan interconectarse aunque se hallen aisladas.

WIMAX es similar en su funcionamiento a WIFI, pero con una cobertura sensiblemente mayor, y obviamente con un coste añadido, siendo uno de los sistemas adoptados por muchos municipios para dar cobertura de internet y otros servicios a los usuarios que se hallan más dispersos o en poblaciones de cierta extensión.

WIMAX opera en dos bandas de frecuencia, una de ellas libre y otra que necesita licencia. Las velocidades de transmisión alcanza los 70 Mb, y una sola estación puede dar servicio a miles de usuarios dentro de un radio de 50 Km.

FUENTES DE CONSULTA

- Evolución histórica de las telecomunicaciones – Rafael Estepa

- Sistemas de comunicaciones móviles – ETSIT

- 25 años de historia de las telecomunicaciones – J.M. Romeo, Javier Romero

- Sistemas de comunicación inalámbricos – Josep Prieto Blázquez

- Estándares en tecnologías inalámbricas – Alberto Escudero Pascual

- La Revolución inalámbrica – Juan J. Yunquera Torres

- El impacto del 5G – Evoca

- Redes inalámbricas – Jordi Salazar

- La Internet de las cosas – Karen Rose, Scott Eldridge, Lyman Chapin

- Tecnologías 3G, 4G y 5G – ICADE